新兴的以存储器为中心的芯片技术有望解决当今系统中的带宽瓶颈问题,并提高运行速度和降低功耗。存内计算技术背后的想法是使存储器更接近处理单元,以加快系统速度。

一些新型器件表现出了适用于新型 AI 架构或计算范式的独特特性,如逻辑器件的非易失性、可重构性、高计算密度等。存内计算中逻辑计算和内存合并的结构(包括数字和模拟)代表了一种前景光明的 AI 芯片架构方法。

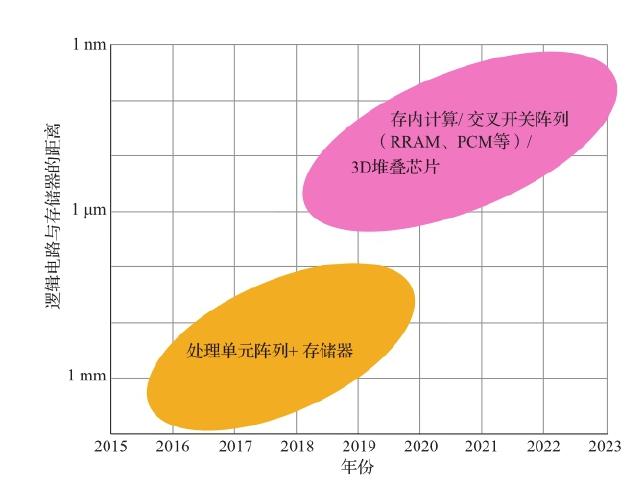

图 7.11 为逻辑电路(处理单元)与存储器之间距离的发展趋势。在没有使用存内计算之前,只能依靠尽量把存储器靠近处理单元来缩短它们之间的距离。而存内计算把逻辑电路直接嵌入存储器中,这样就把它们之间的距离降到了 10nm 以下。

图 7.11 逻辑电路与存储器之间距离的发展趋势

图 7.11 逻辑电路与存储器之间距离的发展趋势

将计算功能从单独的 CPU 推入内存为系统架构师和程序员带来了新的挑战。为了使存内计算被带有各种工作负载的 AI 系统采用,而又不给大多数程序员带来沉重负担,必须解决许多挑战。这些挑战包括以下几个方面。

(1)如果仍然以现有存储器为基本器件,如何对现有的存储器件只作最小程度的改变。一般来说,说服现有的 DRAM 或 SRAM 生产商对已有电路和工艺作出太大变动是非常困难的。

(2)如何能够轻松地对存内计算系统编程,做出良好的编程模型,还有库、编译器和工具支持 [132] 。

(3)如何设计利用存内计算的系统和系统软件(如存内计算逻辑代码的运行时调度、数据映射等)。

(4)如何为存内计算设计高性能数据结构,其性能要优于多核计算机上的并发数据结构。

(5)如何克服器件本身的不确定性和不一致性(如对工艺、温度和电压的依赖性),以及存内计算所需要的模拟计算特征(如噪声问题),解决封装和热约束问题等。如果使用新型 NVM,需要配合适当且灵活的接口设计。

所有这些

(本章节未完结,点击下一页翻页继续阅读)