芯片计算能力的巨大提升及大数据的出现,使得神经网络中具有更高复杂性的「深度学习」(即深度神经网络,DNN)又一次得到人们的广泛关注。辛顿等人 2006 年提出了「深度信念网络」这个概念,有力推动了深度学习算法的应用。与其他传统机器学习方法相比,深度学习有着明显的优势。

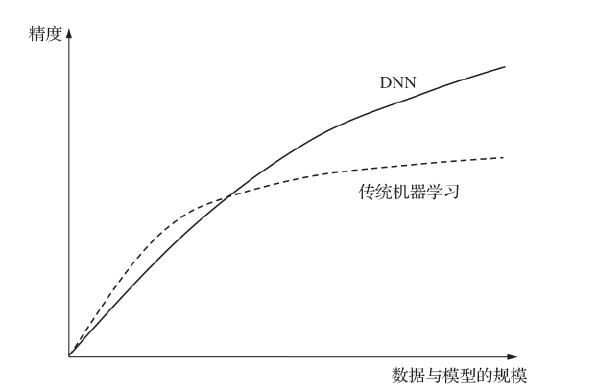

图 2.1 为传统机器学习算法与大型 DNN 在图像、语音识别领域的精度比较。深度学习比传统方法更具吸引力,除了算法本身的优势,主要还是由于数据量和芯片计算能力的不断提高,这导致了近年来深度学习技术的「寒武纪大爆发」。

深度学习的实质是构建具有很多层的神经网络模型(保证模型的深度)和使用大量的训练数据,让机器去学习重要的特征,最终使分类或预测达到很高的准确性。深度学习基于感知器的模型,模仿人脑的机制和神经元的信号处理模式,可以让计算机自行分析数据,找出特征值。

图 2.1 传统机器学习算法与大型 DNN 在图像、语音识别领域的精度比较

图 2.1 传统机器学习算法与大型 DNN 在图像、语音识别领域的精度比较

为了加速深度学习计算,更多地开发硬件是很自然的想法。半导体制造商开发出了一些 AI 芯片(深度学习加速协处理器)来处理深度学习。深度学习有各种各样的模型。例如,目前谷歌数据中心普遍使用以下 3 种 DNN。

(1)多层感知器(Multilayer Perceptron,MLP)。MLP 的每个后续层是一组非线性函数,它们来自先前层所有输出(全连接)的权重和。

(2)卷积神经网络(CNN)。在 CNN 中,每个后续层是一组非线性函数,它们来自先前层空间附近输出子集的权重和。权重在空间上复用。

(3)循环神经网络(Recurrent Neural Network,RNN)。RNN 的每个后续层是权重、输出和前一状态的非线性函数的集合。最受欢迎的 RNN 是长短时记忆(Long Short-Term Memo

(本章节未完结,点击下一页翻页继续阅读)